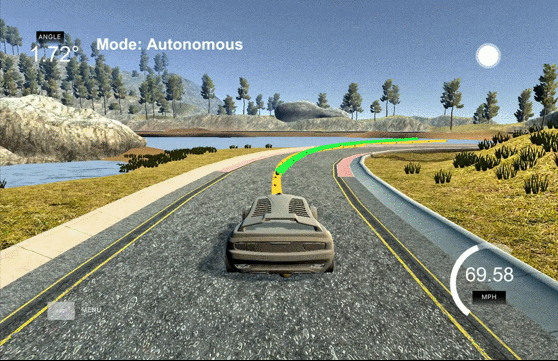

停了半年 的 Udacity Self Driving Car (SDC) Program, 終於又開始了. 做為 Term3 的第一個 Project, 我抱著高度的期待. 不過完成後, 有點小失望. 失望的原因是這個 project 跟課程上的連結感覺不是那麼明顯. 例如課程上有講到 A*, hybrid A* 的算法, 但 project 是模擬 highway drive, 因此 A* 比較不適合 (適合在 parking lot 場景). 另外也有提到怎麼降低 jerk (加速度的微分, 主要是不舒適的來源), 當參考內容是很好, 不過在寫 Project 時感覺也不大需要.

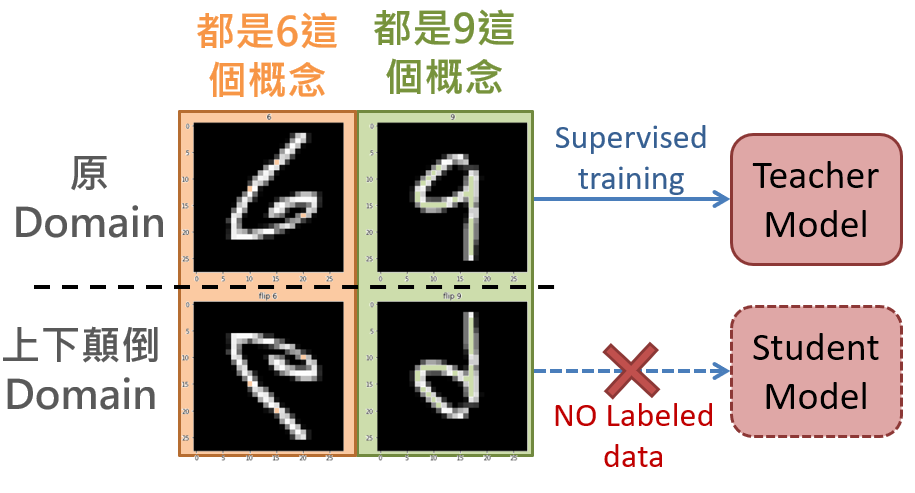

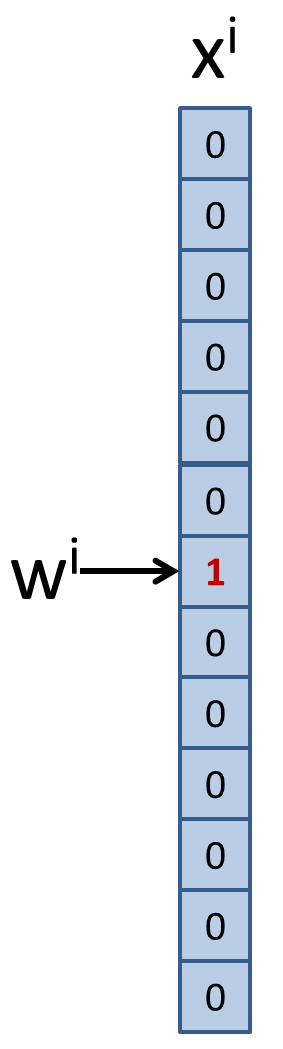

這篇就是個紀錄, 會很水. 方法很簡單, 一張圖解決: