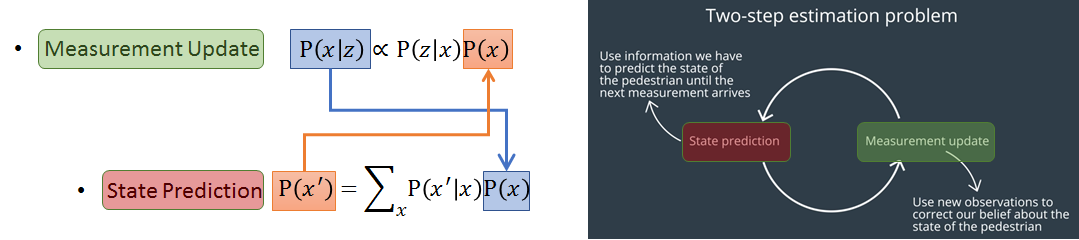

Bayes Filter Introduction

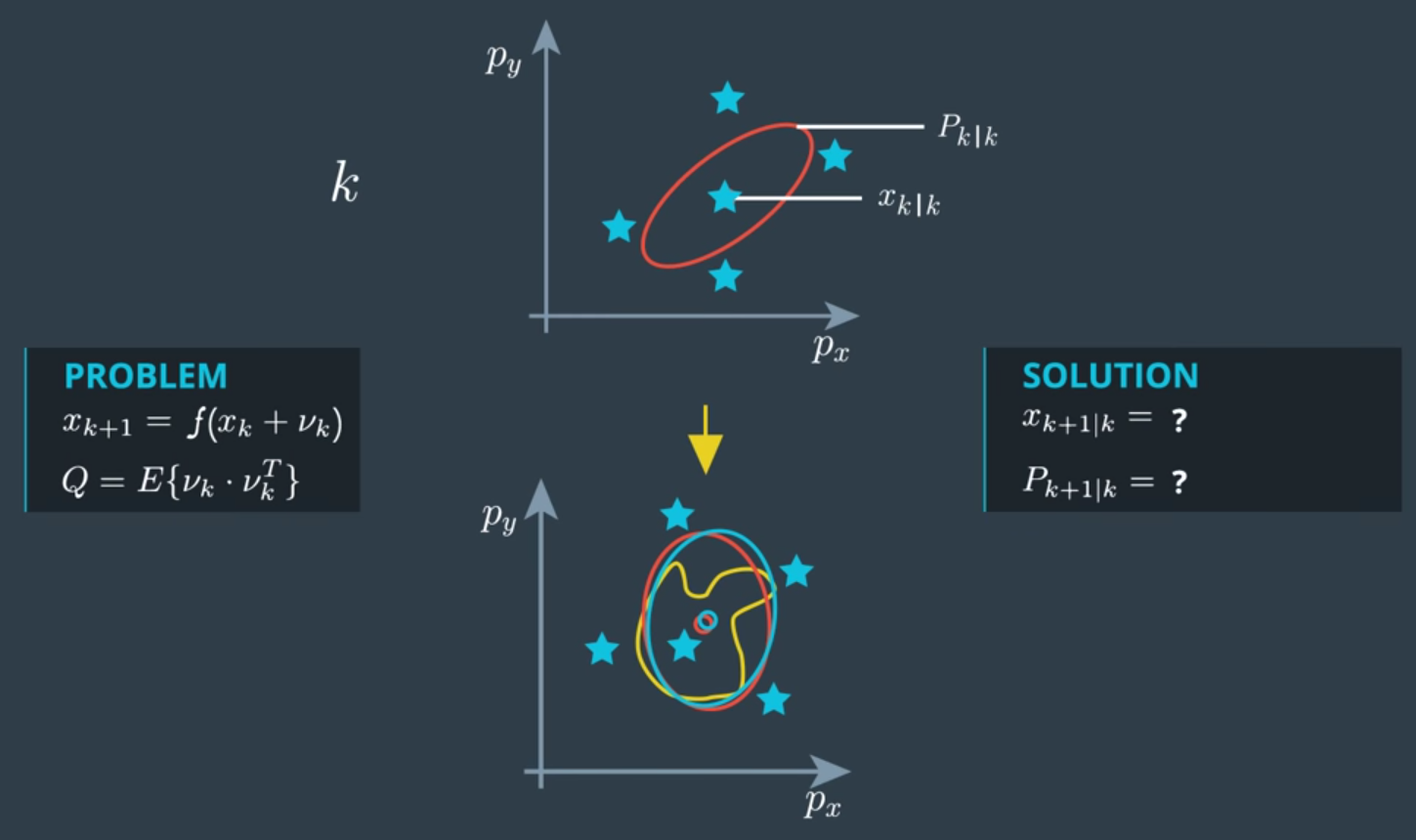

前幾篇討論了很多 Kalman Filter 以及它相關的變形,如: EKF and UKF。這些方法我們都可以放在 Bayes Filter 的框架下來看,這麼做的話,KF 就只是其中一個特例了 (都是高斯分布的情形)。而如果我們只考慮幾個離散點的機率,並用蒙地卡羅法來模擬取樣的話,這種實作方式就會是 Particle Filter 。所以掌握了 Bayes Filter 背後的運作方式對於理解這些方法是很有幫助的。

一些變數的意義仍然跟前幾篇一樣:

- z: measurement,也就是我們實際上經由 sensor 得到的測量值 (會有noise)

- x: state,我們希望估計出來的值,在 Localization 一般就是座標值